利用面部识别技术,这些机器人识别和杀死ISIS的指挥官,斩落了这个组织的头目。在联军和平民伤亡最少的情况下,瓦解了不知所措、士气低落的ISIS部队。

有谁不认为这是很好地运用了技术呢?

事实上,有很多人不这么认为,包括人工智能领域的很多专家,他们最了解研发这种武器所需要的技术。

去年7月,众多人工智能研究人员发表了一封公开信,警告称这种技术已经发展到一定程度,几年以后——而无需几十年——就有可能部署“致命自主武器系统”(Lethal Autonomous Weapons Systems,它还有一个不相称的简称,Laws,意为“法律”)。不像核武器,这类系统可以以低廉成本大规模生产,成为“明天的卡拉什尼科夫步枪(Kalashnikov,即AK-47)”。

“它们早晚会出现在黑市上,落入恐怖分子、希望更好地控制民众的独裁者和想要进行种族清洗的军阀的手中,”他们表示,“在军用人工智能领域开启一场军备竞赛是一个坏主意,应该对超出人类有效控制的攻击性自主武器施加禁令,以防止这样的军备竞赛。”

美国大体上已承诺放弃使用攻击性自主武器。本月早些时候,联合国(UN)在日内瓦举行了有94个军事强国参加的新一轮谈判,旨在拟定一项限制此类武器使用的国际协定。

主要论据是道德层面上的:赋予机器人杀人的代理权,将越过一条永远不应被越过的红线。

因为开展反对地雷的运动而获得诺贝尔和平奖的乔迪•威廉斯(Jody Williams)是“阻止杀手机器人运动”(Campaign To Stop Killer Robots)的发言人,他表示自主武器比核武器更可怕。“如果一些人认为把人类的生杀大权交给一台机器是可以的,人性又何以处之?”

除了纯粹的道德问题以外,还有其他令人担忧的问题。杀手机器人会降低战争中的人员成本,爆发冲突的可能性是否会因此提高?如何阻止这类系统的扩散?当它们出问题的时候谁来负责?

在一个哲学研讨会上,反对杀手机器人的道德理由已是足够明显。问题在于,你越是近距离地观察它们在战争硝烟中可能的用处,就越难分辨出道德的界限。(有限自主的)机器人已经被用于战场上,应用在拆弹、排雷和反导系统等。它们的应用范围还将大为扩大。

据新美国安全中心(Center for a New American Security)估测,到2018年,全球范围内在军用机器人方面的支出将达到每年75亿美元。相比之下,该机构预测用于商业和工业机器人的支出将为430亿美元。这家位于华盛顿的智库支持进一步利用这类系统,主张它们能够显著提高“作战人员取得凌驾对手的绝对性优势的能力”。

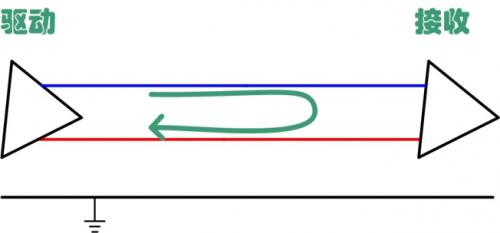

军工界用其最爱使用的置身事外的论调,对机器人不同的自主等级进行了区分。第一类被称为“人在环中”(humans-in-the-loop),包括被美军和其他军队广泛使用的“捕食者”无人机。即使一架无人机或许能够识别目标,还是需要一个人类来按下攻击按钮。就像电影《天空之眼》(Eye in the Sky)生动地体现出来的,这类决策可能会给人带来道德上的痛苦,你需要在打击关键目标和造成平民伤亡的风险之间进行权衡。

第二级的自主是“人在环中系统”(humans-in-the-loop system),人对机器人武器系统进行监督,包括防空炮。但现代战争的速度和强度让人怀疑这种人类的监督能否形成有效控制。

第三类是“人在环外系统”(humans-out-of-the-loop system),比如完全自主的无人机,这种可能是最致命的,但也很可能是最容易禁止的。

人工智能研究人员通过发表公开信,引起人们对这场辩论的关注,这一举动当然值得赞扬。军备控制专家在帮助定义和应对这一挑战方面起到有用的作用,但他们的行动步伐却慢得让人沮丧。“这是一次有价值的对话,”新美国安全中心的保罗•沙勒(Paul Scharre)说,“但这是一个极其缓慢的过程。”

就像在其他很多方面一样,我们的社会在试图理解快速变化的技术现实方面就已穷于应付,更别提加以控制了。

『本文转载自网络,版权归原作者所有,如有侵权请联系删除』

热门文章

更多

热门文章

更多