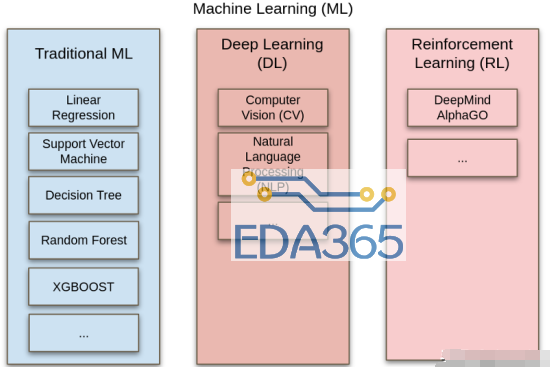

理论上,诸如深度学习、脸部辨识、先进绘图处理等等新学科,对于希望更新其STEM课程的各大专院校计算机科学(CS;EETT编按:台湾的大专院校多称为「资工」)与电子工程(EE)系所来说,似乎是非常容易拿来利用。

毕竟在商业媒体上充斥着对于神经网络以及利用大数据数据集进行图形辨识之各种垂直应用的大量宣传。拥有广泛基础的学术单位可以选择几个擅长的领域,例如医学或是工业自动化,然后将新开发的芯片或子系统架构,用来为那些垂直领域编写专属应用程序。

听起来很简单,对吧?这种模式以往在通讯以及嵌入式处理技术上都行得通。但是学界在未来几年会遇到基础性的速度障碍,有可能会妨碍建立有效的标准;最显著的问题就是在垂直领域进行高阶程序语言的简单扩展。

我们已经看到很多希望在软件方面有杰出表现的学校,以及那些希望子女未来出社会能找到好工作的学生家长们,把「写程序」当作能实现美梦的魔咒;但是,随着AI进一步普及化,所有被追捧的、关于编写程序的训练再也不那么重要。

在游戏以及嵌入式领域,已经由使用C++、JavaScript或Perl等语言明确定义的环境,转变为自动生成程序代码模块,在此软件程序设计师的天才已经接近被边缘化。再往下一个世代发展,深度学习与图形辨识的顶尖平台,将抛弃对人类程序设计师的需求。

因为这类硬件平台并不是以传统意义进行编程,它们是在机器层级由大型数据集进行训练,几乎不需要高阶程序语言。AI开发者在十年前就已经意识到这种转变,但很少有学校的CS、EE系所开始在课程上做调整,以因应这样的变化。

软件模块自动生成趋势并不意味着传统程序语言的消亡,而是那些程序代码会被「降级」为类嵌入式(embedded-like)的状态。事实上,仰赖高阶模块以及非编程训练平台的风险在于,以编译或面向对象语言编写程序的集体知识可能逐渐消失,就像是关于BASIC与FORTRAN等程序语言的知识也不复存在。

因此教育家们需要在保存高阶程序设计的学术知识,以及避免让学生与家长认为只要培养C++或Perl等程序语言专长就能找到好工作的两个面向之间取得平衡。

还有一个刚出现在工程系所的更大问题是,学术机构如非营利组织与政府机关,面临越来越多包括合规测试、学习成果导向结果之量化,以及为新领域应用复制课程等方面的需求。然而连领先的AI研究学者都还无法解释他们的系统是如何能针对困难问题达到优化结果。

在一些早期使用案例,例如自动驾驶车辆,美国交通部(Department of Transportation)已经遇到了关于「黑盒子」数据输入的最简单版本问题,如果其数据集无法在单一或多个面向反映真实世界,像是自驾车那样的系统可能会导致灾难性的失效。这种「大型多元数据集的充分性与完整性」挑战,在许多垂直领域可能会是深度学习的挑战,但这只是神经网络因本质可能会带来的更大问题之中,最简单的一种。

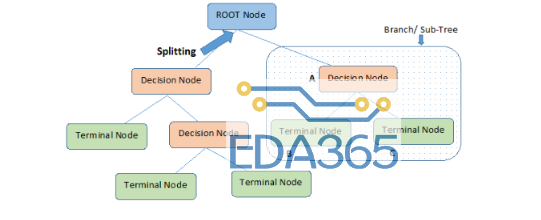

在多个模拟神经元之间使用多个隐藏的卷积连结层、未经训练的神经网络类型取得了最大的成功;AI研究人员能笼统地解释隐藏层中的倒传递(back-propagation)以及基因算法,但无法详细解释神经网络是如何达成其结论,以及该网络是如何调整其突触权重(synaptic weights)来改善其答案。

简而言之,产业界最优秀的工程与数学人才,也不了解神经网络为何能运作地如此出色,就算到未来,人类AI专家能掌握个中窍门的可能性也很低,遑论让他们向一般听众解释。

计算机历史学家George Dyson提出过一个对于深度学习非常重要的概念,:「任何一个简单到能够理解的系统,不会复杂到能拥有智慧的行为;而任何复杂到足以表现出智能行为的系统,就会复杂到难以理解。」

很多AI领域的教授将以上的说法戏称为「Dyson定律」(Dyson’s Law),也有人忧虑,寻找「可解释AI」的本身,可能就会是被称为「非确定性多项式时间完全问题」(non-deterministic polynomial-time complete,NP-complete)的数学题──这类似旅行推销员(traveling-salesman)问题,要在多个变量中确定最佳解决方案的难度随着额外的数据点而呈倍数增加;而在所谓的多项式时间内,一个问题很快变成无解。

如果一个拥有深厚数学功底的EE教授都无法了解深度学习平台是如何运作,负责管预算的学校科系负责人又如何应对这种知识鸿沟?

一位要求匿名、拥有大数据数据集背景的算法研究人员,正以契约模式与美国中西大学(Midwestern university)合作,提供广泛的图形辨识技术用于医疗病例检索;她认为这个产业的本质有大部分要归咎于野心过度的大学管理高层。

她指出,有很多学校科系的负责人就算对新学科还不具备充分的知识,就急着要赶上潮流,「当然,他们总是这样,不过深度学习AI是独特的,因为大学审计人员想要的答案并不存在。这些菁英们说:『这看来行得通,但其实我们搞不清楚这到底是怎么回事;』很多管理者应该都不能接受这种回答。」

一家由加拿大滑铁卢大学(University of Waterloo)独立而出的新创公司研究人员,希望能让个别神经层更透明化、更容易解释,同时也为学界提供能简化深度学习垂直应用开发的另一种指标。这家由Alexander Wong创办的新公司DarwinAI,利用一种称为生成合成(generative synthesis)的方法优化突触权重以及连结,以实现小型、可重复使用的神经网络「模块」。

DarwinAI声称其工具不只能更快开发垂直应用,也会是理解垂直深度学习应用程序如何运作的方法──同时让这些应用程序对小型企业与学术机构来说更实用。Intel已经验证了这种生成合成方法,并且与车厂Audi合作应用于自动驾驶车辆架构;这两家公司的早期参与意味着,如果学界希望能利用这种工具组营造公平竞争环境,就必须快点行动。

AI技术缺乏可问责性,并不对任何学术研究带来阻碍,从美国国家科学基金会(NSF)与私人机构赞助的数十个新研究案就可证明。不过这些取得赞助款的单位,还是很担心它们所掌握到的,只是嘉惠了Microsoft、Facebook、Alphabet/Google与AWS等大型数据中心业者的一小部分学科知识。

美国《纽约时报》(The New York Times)在9月下旬公布了一份由Allen人工智能研究所所做的研究指出,美国大学院校在AI方面总是落后,因为他们无法取得集中式企业数据中心的运算能力,就算是一小部分。这个问题有部份是根源于执行深度学习基本任务必备的运算数量呈倍数成长,而Allen研究所与OpenAI估计,六年来该数字增加30万倍。

就算中立机构也沦为被企业控制。Allen研究所是由Microsoft的创办人Paul Allen创立,仍保持独立运作,但OpenAI这个AI分析机构是由Elon Musk以及其他企业高层金援,并且在2019年初从非营利机构成为营利单位,接受了Microsoft达10亿美元的投资以取得受保障的运算资源;尽管OpenAI的分析平台角色仍受尊重,但一些独立分析师担心它是否能维持独立。

NSF也尝试鼓励更多独立软件开发者,而理论上能对学术界的角色产生保护作用。美国伊利诺大学香槟分校(University of Illinois Champaign-Urbana)超级计算机应用中心(Supercomputing Applications)最近取得了NSF一笔270万美元的资金,以发展深度学习软件基础架构,不过这个计划也与IBM和Nvidia有紧密的连结。

在某些特定情况下,美国的大学研究中心就算获得NSF资金,仍会有来自业界的伙伴可能扭转其研究;例如在德州大学奥斯汀分校(University of Texas at Austin)的德州先进运算中心(Texas Advanced Computing Center),包括Intel、Mellanox、Dell EMC、IBM与Nvidia等业界厂商都扮演吃重角色。

像是DarwinAI等新创公司之逐步进展,意味着对于深度学习有更精细了解,而且也能被学术研究者更容易利用的新时代将会来临。认为AI研究方向可能会被特定力量掌控的疑虑,就像70年前美国国防部主导真空管运算技术那样,证明只是夸大其辞。不过显然将CS/EE研究项目整合到整个STEM目标的传统学界模式有必要改革,以传统高级语言为基础的软件教育程序已经过时,只能用以让程序设计师们了解一些历史背景。

在出现能更妥善解释神经网络训练结果的方法出现以前,目前各大学不太可能将实际可行的深度学习研究项目拼凑起来,甚至在那些平台变得更能理解之前,各大学需要检验垂直领域以及特定的优化方法,让其研究项目不至于和那些甚至比最富裕的大学拥有更多运算资源的企业数据中心直接竞争。

『本文转载自网络,版权归原作者所有,如有侵权请联系删除』

热门文章

更多

热门文章

更多