来源:本文内容由 公众号 半导体行业观察(ID:icbank)翻译自「nextplatform」。

编者按:近几年来,无论是国外的谷歌、Facebook,还是国内的百度、阿里巴巴,我们可以看到全球的大型互联网公司都开始涉足芯片设计领域了,且这股趋势看起来有蔓延之势。究竟是什么原因推动了这种情况的产生?日前,国外媒体The next platform写了一篇文章,阐述了这种现象产生的原因。以下为文章正文:

据我们粗略统计得知,云巨头亚马逊、阿里巴巴、百度、Facebook、谷歌和微软都在设计自己的AI加速器芯片。究竟这是当下云行业的一种潮流还是短期现象?相信一千个人有一千个看法。但在我们看来,为特定任务设计定制芯片将成为云产业的主流,届时处理器、网络交换机、AI加速器等领域将会受到深刻的影响。大胆点的观点认为,该领域内的大多数芯片市场将不能限免。

纵观整个集成电路产业链,在一系列新的技术和经济因素推动下,传统的芯片设计和制造模式正在破坏,云巨头涉足AI芯片设计只是大规模定制芯片影响当前集成电路供应链的冰山一角,更多的可能性正在发生。但造成这种现象的原因并不止一个,很多因素的同时发生导致了今日的结果:

1)摩尔定律的死亡;

2)基于多芯片模块(MCM)和系统级封装(SIP)的新架构方向;

3)芯片设计工具逐渐成熟为完整的开发工具链;

4)可授权IP使组装芯片变得容易;

5)多项目晶圆(MPW)使得晶圆厂有能力实现原型制造和小批量生产客户编写的内部软件框架;

6)网络巨头创造的规模,新兴的物联网巨头的影响力也渐增;

虽然晶圆厂有不同的观点,但在很多人看来,摩尔定律实际上已经死了。经过了数十年的发展,现在的晶圆厂已经进入了一个瓶颈期,那就是如果继续缩小晶体管的尺寸,晶体管将变得更不可靠,且功耗会剧增。且随着晶体管的缩小,设计人员现在必须使用额外的晶体管来验证逻辑块是否能产生正确的结果。但是如果设计人员在芯片上封装太多的逻辑,那么供电和散热都会成为一项挑战。正是这种困境让芯片设计师进退两难。

这就导致了以下结果:在追求高性能的前沿应用里,对晶体管数量的需求正在爆炸,但这种爆炸却催生了更大,更热的芯片,但逻辑的速度的提升,却不会变得如想象中那么快。与此同时,较老的制造工艺(例如28纳米)却继续在发生余热,对于越来越多的应用来说,这甚至是最好的选择。

在这种情况下,就使得现有的通用芯片不能满足云服务商高性能和客制化的需求。

面对上述困境,设计工程师想提高芯片性能,还有一个选择,那就是放弃推动半导体技术前进,而是转向追求新架构,达到性能提升的目的。这样的话,他们就可以退回到前一代甚至两代的工艺上进行硅片制造。这样也能够获得更小,更冷,更实惠的芯片。从现状看来,架构是硅设计的新“高地”,很多厂商早已投入其中以获取领先竞争。

例如,英特尔在其14nm工艺上,将其高端的28核服务器处理器“SKYLAKE”至强可伸缩服务器处理器的面积做到了690 mm2。虽然英特尔不再披露其晶体管数量,但作为对比,Nvida采用台积电12nm工艺制造的Volta GPU芯片在815 mm 2的硅面积上集成了210亿个晶体管。

AMD则在其Epyc服务器产品线上采用了不同的方法。Epyc是基于AMD的八核Zeppelin die设计的。每个EPYC处理器中都封装了四个由AMD proprietary 连接的四个Zeppelin die。

AMD创新的Epyc架构是不同架构和设计权衡的结果。与其他处理器设计相比,它使用了不同的互连、逻辑和存储组合。这就使得EPYC的总晶体管数量和芯片面积与英特尔和Nvidia的产品处于相同的范围,但制造成本却要低得多。AMD暗示,在大芯片里,它们的架构还有可能在在单个封装中继续实现微缩。

不同厂商在架构上的尝试,让云服务供应商看到了新的可能。

集成电路EDA产业到现在,eSilicon,Cadence,Mentor,Synopsys等供应商能够为拥有不同预算的开发者提供云托管设计平台,虚拟原型设计和验证服务,降低开发者的预算。虽然设计芯片还做不到像设计网页那样简单,但如果能够从这些厂商获得EDA和IP方面的更多支持,对于芯片新入者来说,是一个巨大的利好。尤其是如果能从他们身上获得可重复结构(repeatable structure)的支持,这更是成功的关键。

所谓的可重复结构可以是高速缓存存储器块(cache memory block,),处理器核心(processor core),存储控制器(memory controller)等部分,也就是那些你可以通过“复制”来增加总吞吐量的功能。这是扩展内存容量和处理器内核增加容量和性能的方式。

可以肯定的是,在未来,聘用足够多的设计人才去设计独特的、拥有高价值逻辑的十亿级晶体管变得几乎不可能。而可重复的结构和并行架构推动了市场需求,并能将数十亿个晶体管放在芯片上。

要获得通用或专用的可重复结构IP,有许多来源,上面提到的EDA公司是一个选择,下面介绍的公司,又是另一个选择。

Arm是数据中心可授权IP的可靠来源;

Wave Computing最近购买了MIPS,这对两者都是好兆头,因为人工智能(AI)IP在未来两年乃至十年,会成为市场关注的热点;

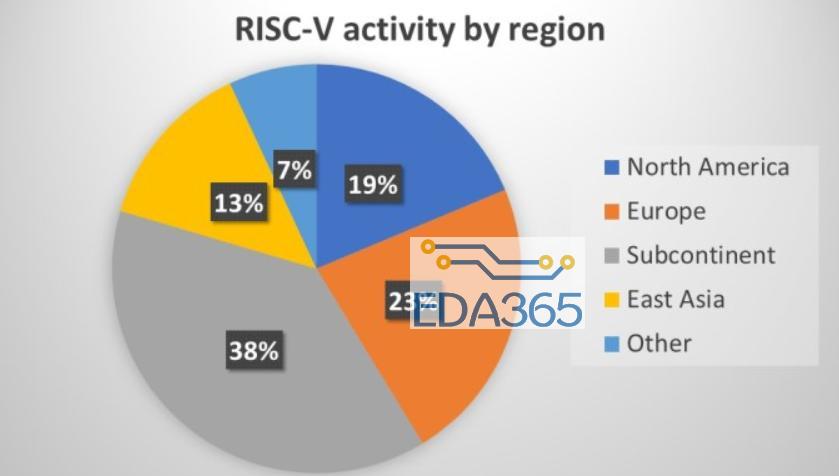

RISC-V旨在通过开源处理器内核使计算密集型可重复结构变得大众化。这个相对新兴的架构吸引了阿里巴巴,Cadence,谷歌,GlobalFoundries,华为,IBM,Mellanox,Mentor,高通和三星等知名厂商成为他们的会员。

如果你所统治的市场影足够大,那么在超现代处理器核心方面,你会有更多的选择,届时:

AMD可能会授权其Epyc服务器架构。

Arm和Qualcomm可能会授权服务器级别的Arm 64位内核。

IBM可能会授权其Power9服务器架构。

另外,在互联方向,虽然AMD凭借其Epyc MCM领先市场,但其他公司也在投资互连IP,这也让你有了更多的选择:

1)英特尔一直致力于其专有的嵌入式多芯片互连桥接(EMIB)点对点片上互连技术的开发,他们还计划将EMIB的子集作为高级接口总线(AIB)进行许可。

2)Arm也拥有各种互连设计,但对于高端基础设施市场,Arm授权其专有的CoreLink CNN(Cache Coherent Network)产品产品。熟悉设计的人都知道,Arm的CCN设计针对其较大的Arm 64位Cortex处理器进行了优化。

3)SiFive的TileLink是应用在RISC-V处理器内核上的片上互连。TileLink看起来就像是AMD的Infinity Fabric协议,而不是Intel的EMIB / AIB点对点互连。

4)USR联盟正在向其会员推进和认证其超短距(USR)系统级芯片(SoC)的互连技术

过去,芯片设计和制造是不可分割的,如果有任何一方对另一方不熟悉的话,合作就无法进行。但随着行业的成熟,某些设计可以与工厂分开进行,只需要大量的专业知识去“转移”。过去,有竞争力的处理器公司需要拥有自己的晶圆厂来推动更出色的性能。但去年AMD的表现证明,设计和工厂分离也可以实现出色的性能。

仅存的的挑战是降低小型设计公司的制造验证设计的价格。多项目晶圆(MPW)制造能力现已在全球范围内提供。MPW在普通晶圆上“放置”了许多不同的设计,因此原型和小批量生产就不必承担生产晶圆的全部成本。现在开发者可以从最大的晶圆厂(如GlobalFoundries,三星和台积电)以及小型和特殊工艺的专业晶圆厂(如KAST的WaferCatalyst,IMEC / Fraunhofer,Leti / CMP,MOSIS,Muse Semiconductor)获得MPW服务和价格。

MPW使小型设计公司和学术研究的开发项目能从晶圆厂获得更好的支持。大的设计客户则可以通过过往的渠道来订购大批量晶圆。

开源操作环境和应用程序代码使Web巨头能够共同设计和优化数据中心基础架构。随着芯片设计和制造进一步商品化,这些公司会发现,去体验和部署包括AI加速器在内的新处理器指令集变得越来越简单。

事实上,人工智能芯片的部署已经在进行中。大多数网络巨头都拥有内部的深度学习模型开发环境,甚至有些还开放给其他开发者访问。重要的一点是,他们当中的大多数正在进行AI芯片设计:

1)AWS已投资Apache MXNet和由亚马逊开发的用于消费设备的AI芯片;

2)百度创建了PaddlePaddle和昆仑芯片;

3)谷歌创造了TensorFlow和几代TPU芯片

4)微软创建了Cognitive Toolkit及其FPGA驱动的Brainwave附加卡;

5)腾讯创建了DI-X平台(具有专有模型和算法)和ncnn(面向移动),并与芯片厂联发科建立了合作关系;

6)阿里巴巴尚未加入软件框架竞赛,但他们已发表了许多关于深度学习架构和算法的原创研究论文,并正在开发一个神经处理单元(NPU);

在另一些云供应商中,IBM拥有Cognitive Computing和Watson服务,并与许多AI加速器公司在OpenPower方面进行合作。在社交媒体领域,Facebook推动了Caffe和Caffe2的发展。

然后有几十家初创公司推出了AI加速器芯片,而Wave Computing在购买MIPS之后,则处于领先的地位。

另外,可以确认的是,很多网络巨头也在投资量子计算,因为他们把它当做神经网络的潜在通配卡加速器,这也不是巧合。

一旦网络巨头在其遍布其全球数据中心基础架构中部署大规模的定制芯片,这意味着它会买入数十十万乃至百万计的芯片。如果每个芯片能提高几瓦的效率,那么整体效率提高则可以很容易就达到数十兆瓦。与此同时,还能解决盈利的新问题,还可以拥有更快的速度和更高的精度。

此外,网络巨头们往往有晶圆厂的关系,这就有利于其建立消费设备的定制芯片,如Google Home和Amazon Dot。如果这些厂商能够有包括AI加速器在内的多款芯片在晶圆厂生产的时候,庞大的数量将会带来很大的经济规模效应。

我们还没有看到这些融合趋势带来的真正影响。和目前AI加速器的尝试一样。这也仅仅只是一个开始。

一个对软件操作环境和深度学习建模语言有控制权的网络巨头也将进入芯片设计领域是一件很容易的事,且是一个很不错的选择。因为他们很容易就能获得最好的EDA工具、开源和可授权的IP模块,然后就可以构建原型芯片,将其布置到全国各地的服务器上。

具体来说,网络巨头进入芯片领域,不但可以定制其整数和浮点的处理器内核,还可以基于这些定制的处理器内核、定制AI加速器、定制的I / O和内存控制器等部件打造SoC。他还可以在其专有的芯片里面优化其软件性能,这在通用的大规模芯片上是很难做到的。

未来,网络巨头可能会设计完全不同的芯片。届时那些专门面向标准化操作环境和标准指令集设计的病毒将不会在这些芯片上执行。黑客需要更好的手段才能访问网络巨头的系统,尤其是这些系统还可能会定期更改的时候。

到时的数据中心,将会是一个截然不同的数据中心。

到时的芯片世界,也将会是一个不同的芯片世界。

『本文转载自网络,版权归原作者所有,如有侵权请联系删除』

热门文章

更多

热门文章

更多