为促进医学研究、保护数据隐私以及改善患者脑肿瘤识别结果,NVIDIA 携手伦敦国王学院(King’s College London)于近日推出了首个用于医学影像分析且具有隐私保护能力的联邦学习系统( federated learning system),标志着在医疗健康 AI 领域实现了突破性进展。

该技术论文在 MICCAI 大会召开期间发布——该会议于 10 月 14 日在中国深圳拉开帷幕,是全球最高端的医学影像会议之一。

NVIDIA 与伦敦国王学院研究人员介绍了该技术的实施细节。

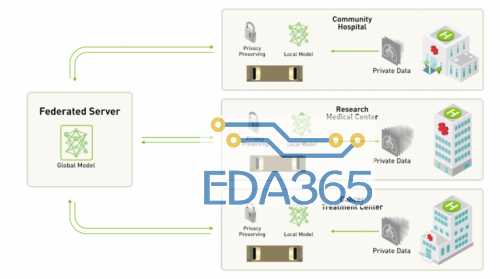

联邦学习(federated learning)是一种能够让开发者与各企业机构利用分散在多个位置的训练数据对中心深度神经网络(DNN)进行训练的学习范式,该方法可以支持各企业机构针对共享模型开展协作,而无需共享任何临床数据。

研究人员在论文中阐述道:“联邦学习在无需共享患者数据的情况下,即可实现协作与分散化的神经网络训练。各节点负责训练其自身的本地模型,并定期提交给参数服务器。该服务器不断累积并聚合各自的贡献,进而创建一个全局模型,分享给所有节点。”

研究人员解释道,虽然联邦学习可以保证极高的隐私安全性,但通过模型反演,仍可以设法使数据重现。为了帮助提高联盟学习的安全性,研究人员研究试验了使用ε- 差分隐私框架的可行性。该框架是一种正式定义隐私损失的方法,该方法可以借助其强大的隐私保障性来保护患者与机构数据。

上述突破性试验是基于取自 BraTS 2018 数据集的脑肿瘤分割数据实施的。BraTS 2018 数据集包含有 285 位脑肿瘤患者的 MRI 扫描结果。

该数据集旨在评估面向多模态与多级分割任务的联邦学习算法。在客户端一侧,研究团队改写了一个原本用于数据集中式训练的一流训练管道,并将其用作 NVIDIA Clara Train SDK 的一部分。

此外,研究团队还将 NVIDIA V100 Tensor Core GPU 用于训练与推理。

相比于数据集中式系统,联邦学习所提供的方法可以在不共享机构数据的情况下实现相当大的分割性能。此外,试验结果显示,隐私保护与受训模型质量之间产生了自然折中。而且,通过使用稀疏向量技术,联盟学习系统可以实现严格隐私保护,且对模型性能仅产生合理的轻微影响。

深度学习是一种从医学数据中自动提取知识的强大技术。联邦学习有望有效聚合各机构从私有数据中本地习得的知识,从而进一步提高深度模型的准确性、稳健性与通用化能力。

此项研究为部署安全联邦学习方面做出了巨大的推动,并将广泛推动数据驱动型精准医学的进步。

APP下载

APP下载 登录

登录

热门文章

热门文章