每年全球有 100 多万人死于交通事故;2019 年美国消费者调查表明,57%的车主表示高级驾驶辅助(ADAS)功能阻止了事故的发生。未来,不管电脑是否能驾驭汽车,未来的交通工具都将离不开人工智能(AI)。有了汽车 AI,出行可能会变得更安全。

出于安全目的,汽车中多传感器融合日渐流行,将来自多个传感器(可能是不同类型传感器)的信息进行组合,即可取长补短,提高决策过程的整体精度或可靠性。事实上,几种传感器的组合是一种行之有效的方法。

但是,人的欲望是无止境的,对技术的追求也是这样,特别是人命关天的汽车。现在,利用 AI 技术进行传感器融合,有效提高了汽车内外环境感测的准确性和可靠性。

从没有智能到人工智能

自从亨利·福特开始大规模生产汽车以来,汽车的功能只不过是一台将汽油或电力转化为运动的机器,把人们从一个地方运到另一个地方。

未来的汽车仍然是一种交通工具,但可以毫不夸张地说,它正在成为一种车轮上的 AI 超级计算机,可以快速处理万亿字节的传感器数据,并对其进行理解,然后向车轮、发动机和制动器发出一个又一个微秒的指令,从而实现 ADAS,最终实现完全自动驾驶。

那么,如何让 AI 在自动车辆技术(AVT)的发展中发挥作用呢?对于工程师来说,技术就是一切,是思考的核心。我们把复杂的技术问题分解成尽可能简单的元素,然后把它们重新组合起来。这时,我们就可以了解事物是如何运作的,并想出办法让事情变得更好。

AI 是我们用来解决传统技术无法解决的问题的工具。它已经存在多年,但是现在有了经济高效的处理器,使我们能够解决以前几乎不可能解决的高度复杂的问题。

AI 的关键是训练,而训练意味着收集大量数据,这些数据可以用来帮助训练神经网络来完成任务。AI 并不适用于每一项工作,但是它可以使我们的系统更加强大。

当 AI 遇上传感器

AI 训练所需的所有数据来自哪里?主要是汽车本身的眼睛和耳朵,也就是传感器。车载传感器主要有三种类型:视觉(摄像头)、雷达和激光雷达(LiDAR)。虽然有些主机厂只使用一到两种类型传感器,但传感器在所有操作条件下都不是完美的,因此撇开成本问题,应该使用三种类型的传感器。不过,所以特斯拉的马斯克说,雷达是人都没有的感官,干嘛要装?人的视觉加大脑处理信息的模式就可以安全行驶。他更看中 AI 的作用。而与马斯克隔空互怼,打出安全牌的小鹏则声称:之后其自动驾驶要采用摄像头+毫米波雷达+超声波雷达+LiDAR 的融合方式,传感器有四种之多!

这些传感器共同创造了冗余,使得感知系统更加强大,这一策略对安全至关重要,同时也保证了汽车在任何情况下都能运行。这些传感器每小时接收超过 40 兆字节数据,AI 在处理这些数据方面起着关键作用——识别、分类和预测车辆周围发生的事情。

Aptiv 高级副总裁、首席技术官 Glen De Vos 认为,对于自动驾驶汽车来说,AI 的使用能够感知环境并采取行动最大限度地安全到达预定目的地。摄像头最早使用了 AI,也是目前使用量最大的设备。为什么?因为只是摄像头没什么用。它捕捉图像,但不知道这些图像是什么,也不知道如何对它们做出反应。这就是 AI 和机器学习(ML)的用武之地。

Glen De Vos

当然,技术人员必须训练系统,对传感器收集的图像进行注释,以便可以告诉系统“那是一条狗,一只猫,一棵树,一个孩子,一个路标。”用于训练系统的图像越多,系统的性能就越好。这对于我们试图确定相机系统到底看到了什么对象的分类特别重要。

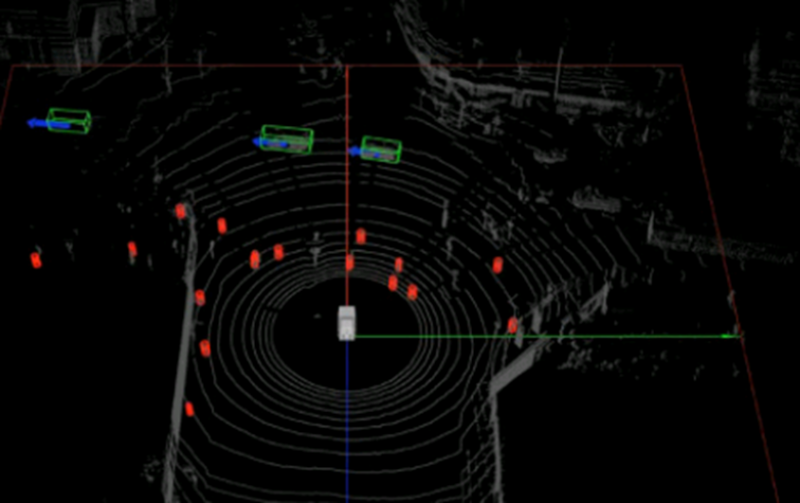

除了摄像头,还有雷达和 LiDAR。虽然人类不可能轻易地看到雷达或 LiDAR 的图像,但令人兴奋的进展是,英伟达、英特尔等公司提供的 AI 工具可以用来训练系统,使它们比人类更好地解读雷达和 LiDAR 图像。如前所述,这些传感器捕获大量信息,这些信息必须通过车辆网络共享,并由车载计算平台进行处理。

利用处理的传感器信息就可以建立一个自动化车辆周围环境的实时模型。然后,使用 AI 来帮助我们预测环境中的所有对象(人、汽车、自行车等)正在做什么和将要做什么(也称为语义理解)。仅仅知道路边有行人是不够的,你还需要预测那个人会做什么。AI 帮助我们发展这种语义理解,这样就可以根据特定情况调整车辆的行为。

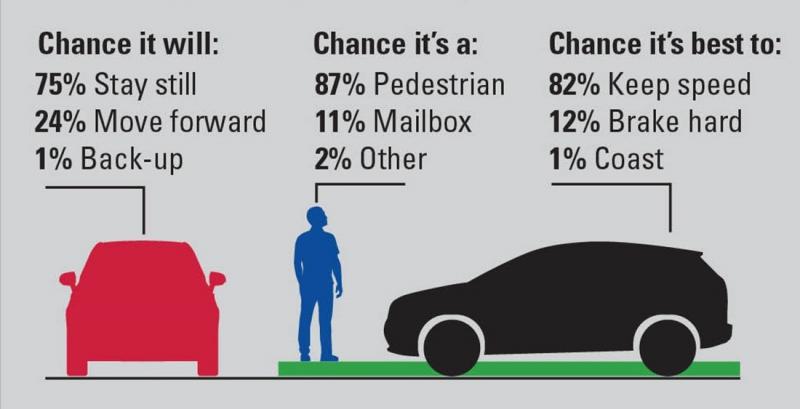

基于大脑神经网络的软件的决定不是绝对的,而是有一定概率。例如,自动驾驶汽车能够衡量行人的概率,决定保持速度、停车或滑行。深度学习是一种帮助神经网络从理论到解决复杂问题(如自动驾驶)的有效方法。

神经网络软件根据概率做出决策

最后,使用 AI 可以优化车辆的路径规划,在给定所有环境约束和变量的情况下求解最优路径。我们不可能为汽车遇到的每一种情况都制定一个规则,AI 却可以帮助我们应对那些边角情况。在确定性框架内使用基于 AI 模块的方法可以分而治之:明确通用规则和策略控制车辆的总体行为;基于 AI 的算法帮助我们解决最复杂的边角案例。

用 AI 理解人类行为

美国交通部说过:“人类的选择与 94%的严重车祸有关。”因为交通中最危险的是驾驶者。

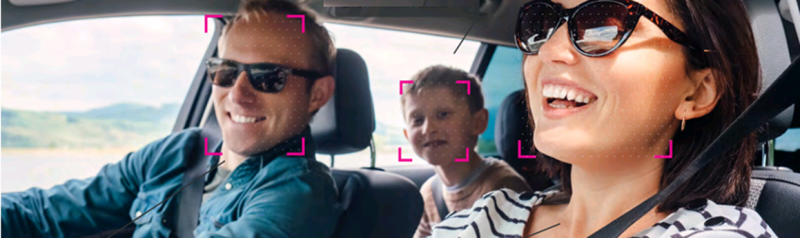

AI 技术可以处理来自摄像头、麦克风、生物传感器甚至雷达的实时数据,实现人的情绪和活动感测,为安全驾驶提供帮助。像 Affectiva、Guardian Optical、Eyeris、Smart Eyer、Vayyar Imaging、Seving Machines、B-Secur、eyeSight、Nuance Automotive、BeyondVerbal 和 Sensay 等一些之前名不见经传的公司都在研发这类技术。

情绪和活动感测可以改变甚至推翻人的危险选择以拯救生命。它不仅能感测到驾驶者醉酒、压力、困惑、分心或嗜睡;还能识别并关注车内人与人之间的互动,然后利用 AI“理解”人类行为,以支持人类生命、健康和幸福的方式作出回应。

在车内可能发生突发的事情,增加了事故的风险。驾驶者可能看到一些令人不安的事情,如路边的车祸,或被车撞伤的动物,或做一些让人分心的事情,如咖啡洒了或手机掉了。情绪和活动感测可以感测何时发生这种情况,并采取与安全相关的行动,例如短暂进入自动模式并减速,直到驾驶者恢复过来。在紧急情况下,即使驾驶者失去知觉或丧失行动能力,汽车也应该能够拨打急救电话,甚至自动开到医院。

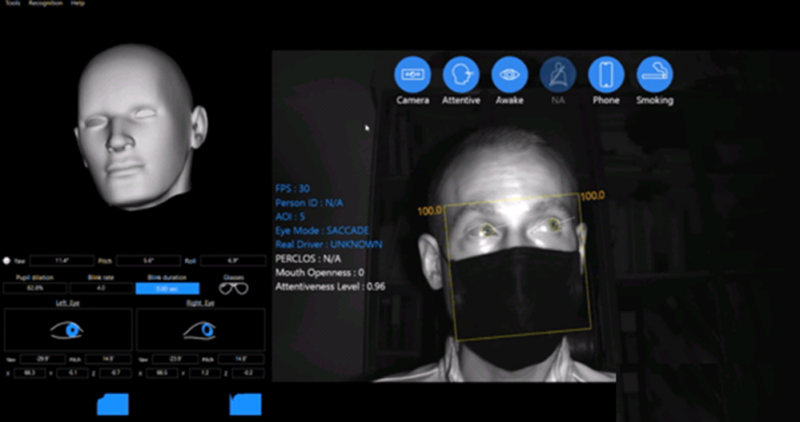

就在疫情日盛之际,初创公司 Eyesight Technologies 在其驾驶员感知平台上增加了戴口罩驾驶员检测功能,已满足美国疾病控制和预防中心的要求,同时帮助卡车司机和公共汽车运营商监测驾驶员工作时长。

戴口罩也可以监测

但安全并不是唯一目标。Eyesight 视觉技术产品管理副总裁 Tal Krzypow 说:“专家们的共识是,情感和活动感测将从人类驾驶的汽车开始,然后在未来自动驾驶汽车时代继续发展,它将被用来‘服务和取悦’车内的人,提供从功能安全到娱乐岛的一切。”

Tal Krzypow

这种转变带来的一些新功能将把安全性和满意度结合起来,例如通过“凝视感测”,你可以问汽车问题:“那栋楼是什么地方?或“那家餐馆开门吗?”不用手机就能得到答案。

在基于传感器的汽车中,当外部传感器感测车道线、不断变化的交通信号、自行车速度和位置及无数其他因素时,车内强大的传感器将感测驾驶者和乘客,以理解更复杂的因素:人的情感、注意力和行为。

用什么传感器呢?最主要的候选设备是集成在后视镜或车顶模块中的摄像头,用来观看人的活动和读取面部表情;通过语音语调来感测情绪的麦克风;还有方向盘或安全带上的直接传感器。

汽车情感 AI 功能几何?

在汽车挑战中,道路安全仍然是重中之重。欧洲新车安全评鉴协会(NCAP)要求加速部署驾驶者监控系统,使用摄像头等传感器来感测驾驶者疲劳、力心和遗忘儿童;同时满足消费者期望的舒适和娱乐出行体验。为了实现这些先进安全功能,主机厂需要深入了解车中发生的事情,方法是采用汽车 AI 座舱感测(ICS)解决方案。

同为初创企业的 Affectiva 首席科学官和联合创始人 Rana el Kaliouby 博士说:“将基于深度学习的软件集成到联网车辆平台,将使主机厂、按需出行供应商和车队管理公司了解车辆内人类体验的方方面面(包括情感),制造出智能车辆。汽车级座舱感测 AI 的加快部署,将增强道路安全并重新定义出行体验。”

Rana el Kaliouby

Affectiva 基于深度学习的专利软件使用摄像头实时感测座舱,包括驾驶者和乘客状态——从复杂微妙的情绪和认知状态(如困倦和分心),到占用率、活动、物体和儿童座椅感测。主机厂、Tier 1、共乘服务提供商和车队管理公司可以使用 AI 提供优化的乘客体验和先进安全功能。

感知舱内与人有关的活动包括:

·驾驶状态:了解驾驶者复杂和细微的状态,如困倦、分心和愤怒程度,以确保道路安全;深入了解驾驶者与车辆系统和其他乘客的互动,以改善驾驶体验。

·乘客状态:通过调整音乐、灯光和温度,深入了解乘客的状态,提高他们的舒适度。了解乘客对内容的参与度,可以提供个性化建议,并有机会将媒体数据货币化。

·座舱状态:深入了解座舱状态有助于个性化安全功能(安全带、安全气囊)、内容(视频、音乐和广告)和座舱环境(加热和照明);还可以感测是否有儿童或物品被遗忘。

舱内感知功能

随着汽车情感 AI 慢慢进入汽车,主机厂和出行服务提供商必须清楚地了解车内感测技术,并告诉消费者该技术的作用、收集的数据以及如何存储和使用这些数据,以建立起对 AI 系统的信任。

机器学习让雷达更智能

机器学习是 AI 的一个子集,是通过不同场景中的经验来训练系统的能力。随着车辆变得越来越自动化,开发人员可以使用机器学习训练系统来识别对象,并用更少的数据更好地解释其环境。

机器学习帮助雷达解决的一个挑战是边缘感测。雷达波长越长,分辨率越低,导致目标分辨力不足,很难分辨出目标的边缘位置。这时,解释数据和解析场景就变得困难了。工程师们正在研究提高雷达分辨率的方法,例如从目前汽车中常用的 77GHz 提高到 120GHz 或更高,同时相应减少波长。这使得同样尺寸的传感器具有更高的分辨率。

然而,即使是现在的雷达,当数据很难通过标准算法描述时,机器学习也可以帮助描述不同场景。开发人员可以向机器学习系统展示特定类别对象的许多示例,还可以了解信号是如何被有许多反射点的复杂对象散射的。它可以利用上下文信息,甚至可以从摄像头、LiDAR 或高清地图提供的同步数据中学习,根据雷达信号对物体进行分类。

明智地使用机器学习可能会有更多的好处。我们可以做一些经典预处理,然后将机器学习应用于雷达提供的所有原始数据,而不是采取暴力手段,只将机器学习应用到那些有意义的部分。

此外,机器学习可以从雷达生成的数据中收集距离和自由空间感测的信息,从而提供接近 LiDAR 的结果,但成本更低。潜在的节省来自于不必在每个传感器中构建处理、RAM 和通信的并行方法,也来自于使用域控制器(DCU)集中软件所获得的效率。较低的成本意味着即使是标准或入门级车辆也可以配备这种救生技术。

具有挑战性的几个场景

当涉及 ADAS 系统时,人类驾驶者每天都会遇到许多难以解决的问题:如果路上有物体,车开过去安全吗?如果相邻的卡车造成了盲点,车辆应如何调整其行驶?机器学习加上雷达可以解决这些和更多的问题。看看几个例子:

·可否安全驶过物体:道路上的小物体或碎片会带来挑战,特别是在高速行驶时。人类驾驶者通常认为他们有能力判断道路上的物体是否可以驶过还是并入其他车道。他们估计不到这个物体有 5 厘米高还是 10 厘米高,只是凭过去的经验和直觉行事。

车道内物体,是过还是绕?

具有机器学习功能的雷达能够跟踪 200 米处的小物体,这使得车辆有足够的时间变换车道或安全停车。系统也可以用安全驶过物体和不驶过物体进行训练。程序可以创建整个处理链的一部分,将这个问题作为对象分类的一个特殊子集——“过度驾驶”:是还是非?并将答案传递给可以在需要时采取行动的软件。

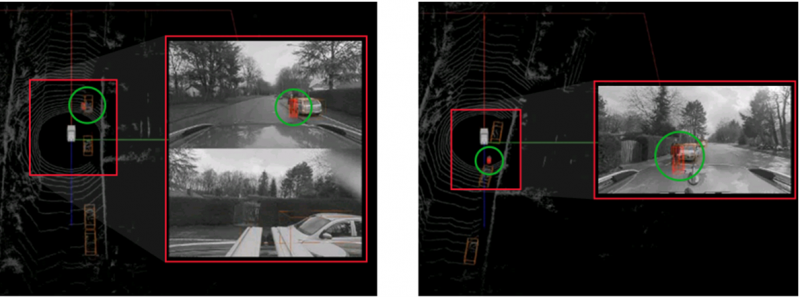

·弱势道路使用者:易受伤害的道路使用者包括骑自行车和骑摩托车的人。这一直是监管机构特别关注的范畴,因为这些人在发生碰撞时几乎没有保护措施,而且他们可能比其他车辆更难识别。与传统雷达信号处理相比,机器学习可以减少 70%的误检率,传感器的融合可以进一步提高感测效果。

·行人和移动物体:行人会给任何类型的传感器带来独特的挑战,特别是在混乱的城市环境,许多行人可能会穿过一条街道,朝不同方向行走。不过,用雷达数据加先进机器学习技术可以帮助车辆在混乱环境中看到行人,甚至可以在停着的汽车后面或遮挡障碍物后面发现他们。

发现混乱环境中的行人

发现人行道附近的行人和停放的车辆

后部驻车期间的行人警报

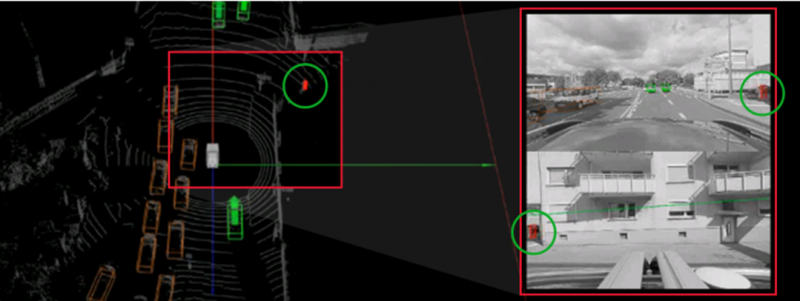

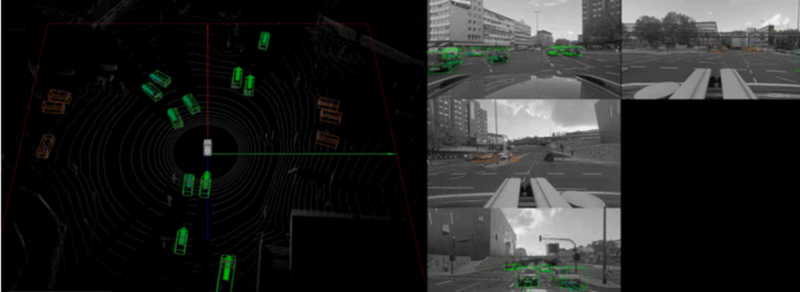

360 度感测的传感器融合方法将来自车辆周围不同传感器的输入集中在一起。如果车辆配备了足够的传感器,就可以 360 度查看其环境,而完整的图像有助于车辆做出更好的决策。机器学习帮助系统识别该范围内的对象,将其分类为汽车、卡车、摩托车、自行车、行人等,并确定它们的方向,还可以区分和识别静止或缓慢移动的物体。

区分和识别静止或移动的物体

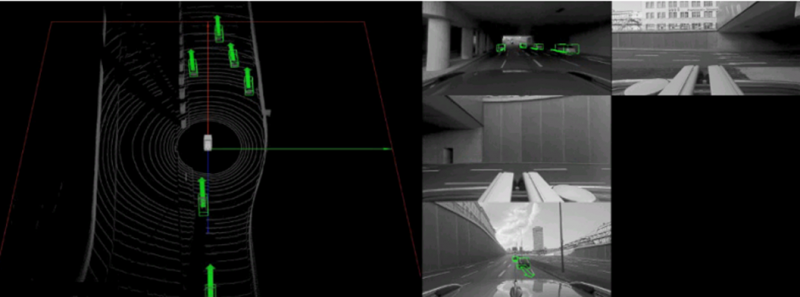

·隧道内:对于雷达来说,隧道历来是一个具有挑战性的环境。隧道壁是一个反射面,会形成大量感测数据,从而使雷达无法找到目标。而且,这些反射可以来自高仰角,使静止目标很难被识别。此外,隧道通常会有风扇,旋转的叶片可能会使雷达误以为看到了移动的物体。

将机器学习应用于雷达数据处理,系统就能够以比传统方法更高的精度滤除感测中的噪声,从而更好地解释隧道和其他封闭环境中的雷达回波,对风扇等目标进行分类,并有效地解决雷达的隧道挑战。

滤除隧道感测中的噪声

从机器学习开始

主机厂希望其全系列车型都具有主动安全功能,他们需要具有成本效益且能够在具有挑战性的条件下传输数据的传感器,还需要从数据中获取最有用信息的智能。而机器学习与传感器的组合恰恰可以最大限度地利用雷达和其他传感方式收集的数据。

现在,主机厂可以在强大的传感和感知技术基础上,利用机器学习等实现 AI 的方法,为不同级别的自动驾驶开发不同的功能,并解决最具挑战性的边角案例问题。

APP下载

APP下载 登录

登录

热门文章

热门文章